活動報告: データ利活用分科会 第10回イベントレポート

みなさんこんにちは!2023/2/16、データ利活用分科会では記念すべき10回目のイベントを開催しました。このイベントでは Google アナリティクス 4 がテーマ!!Web site の解析に使っている方も多いのではないでしょうか?ビジネスを加速させるためには顧客のエンゲージメントを測定してアプローチを考えるのは重要なプロセスです!

なお、今回はそんな GA4 のデータの活用、そして資格取得まで幅広いテーマを発表いただきました。それでは実際のイベントの模様をどうぞ!

目次

基調講演

「Google アナリティクス + Google Cloud + ads data hub でちょっと高度な広告施策」

電通デジタル / 福島ゆかり様

基調講演は、株式会社電通デジタルの福島ゆかりさんより、 Google アナリティクス 4 と Google Cloud、ads data hub を活用したビジネスユーザーでもできる広告施策についてです。

福島さんは、大手SIer、Google広告の運用を経て、データテクノロジーチームへ異動し、現在はGoogleCloudのリセリングを行っている経験をお持ちです。

高度な広告施策の検証の事例紹介ということでわくわくします。

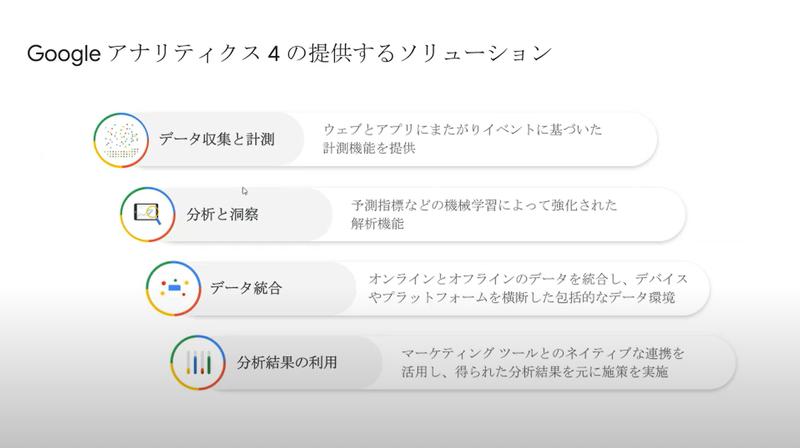

まずは、Google アナリティクス 4(以下GA4)で何ができるかを説明してくれました。GA4 は、ウェブやアプリ間を1ID化し、データを解析できるツールです。機能としては、データ収集ができるとともに一定の法則に沿った計測を行ってくれます。

従来の UA からGA4になったことで、予測が可能となり、分析と洞察が深堀できるようになりました。

そして、生ログがBigQueryにエクスポートできるようになったため、データ統合が容易になりました。

分析結果は、マーケティングツールと連携させて使えるようになり、クラウドと一体化させやすい解析ツールになっています。

GA4では、タグの管理にGoogleタグマネジャーで作るワンタグを使っており、簡単に扱えます。UIもカスタマイズできます。Firebaseのイベントのロギングと同様に、ウェブサイトのイベントを使った分析がGoogleAnalytics側でも可能になりました。

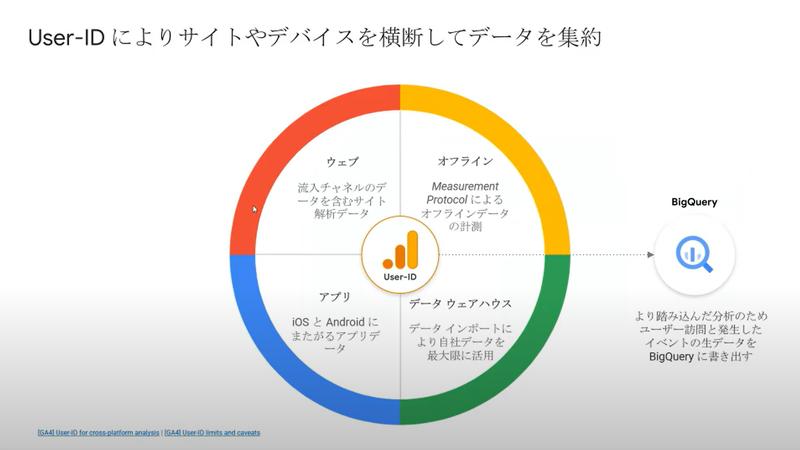

Cookieに頼りきれなくなった関係で、お客様の会員IDなど固有のUser-ID を持たせることで、クロスプラットフォーム間の計測ができるようになりました。

データストリームを使って、アプリ内の行動とWEBの行動に横断的に分析できるようになったのが大きな変化です。

とても便利ですね。

解析ツールの初心者の方にとっては、計測設計をするのが難しいです。

しかし GA4 では、ある程度自動的な計測イベントとして用意されているので親切です。慣れてくると、任意設定を活用することができるようになります。

またコンバージョン設定も任意で設定できるようになっています。

User-IDの使用によって、デバイス間をまたぐ行動も分析できるようになりました。

無償版ではUI上で期間の制限がかかります。新しいGA4では14か月しか保存していないので、昨対でデータ分析したい方には、BigQueryにエクスポートして使うことが便利だそうです。

このあたり、データの蓄積に関して、BigQuery連携が活かされる部分です。

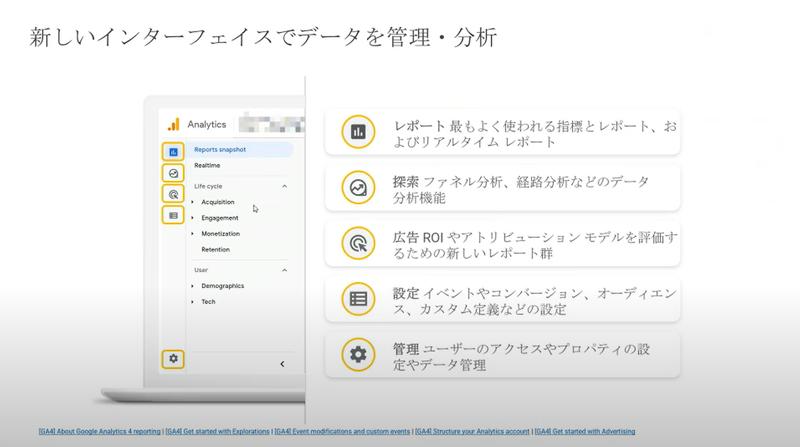

BIツールやクエリを駆使できなくても、リアルタイムの情報に関しては、GA4 のダッシュボードのレポート画面が充実しています。探索ファネルレポートや広告ROI等の評価レポート、イベントやコンバージョンなどの設定、データ設定を行えます。

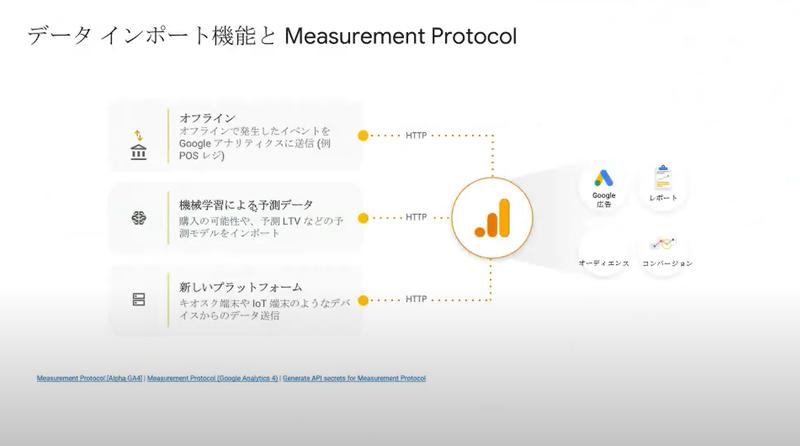

GA4 のすごいところはタグの取れないものもインポートして、データ統合させてくれるところです。この機能が、無償版でも使えるようになりました。

MeasurementProtocolという機能でプログラムを組んでアップロードすることもできます。

福島さんは、VertexAI を使うことが多いため、GA4 の機械学習を使わずに活用しているそうです。様々な手法が簡単に取れて、柔軟性が高いですね。

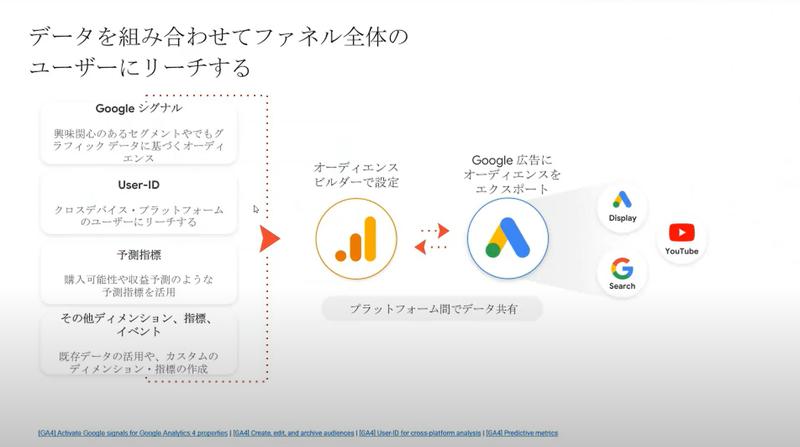

そして何より、GA4 のデータとGoogle広告の直接共有ができます。他の解析ツールとは一線を画している点です。広告だけで追いかけられないユーザーにもWEBやアプリの行動履歴を統合することでお客様にリーチすることができます。

広告とクラウドを持つ Google の強みですね。

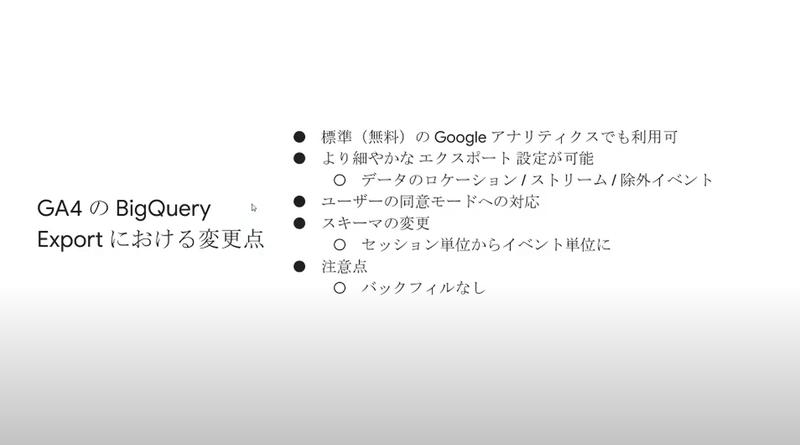

今回の変更で、無償版でもBigQueryのExport設定をできるようになりました。また、Export 前に除外したいものを事前に設定しておけるところも便利です。セッション単位でなく、Firebase の行動履歴の単位に変わっていることは注意点です。その他にも数点変更が加えられています。

専門的な分析をしたい場合は、BigQuery に出力することでより専門的な分析を行うことができます。さらにGA4 の探索レポートに戻して、メンバー間で共有することができます。

ここからは、実際のユースケースをご紹介いただきました。

電通デジタル様は、広告配信からデータ解析、クラウド開発について、組み合わせソリューションを提供しています。4年連続でアワード取得は素晴らしいですね。

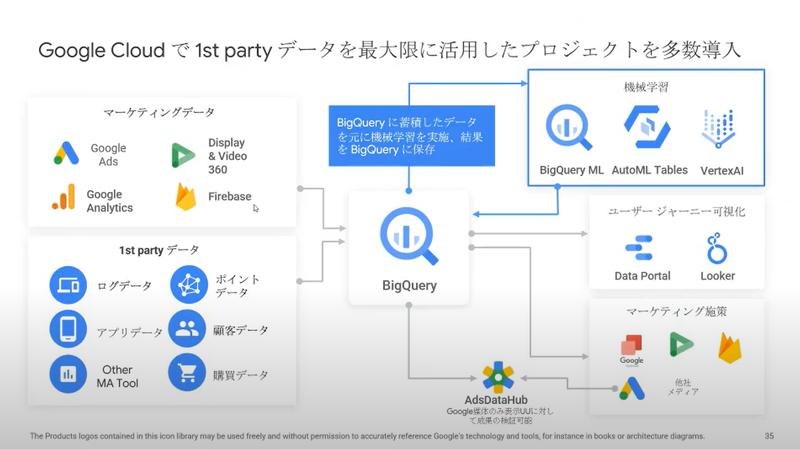

1st party データを活用したサービスの事例を紹介いただきました。

AdsDataHubで紐づけて、タグでは取れない閲覧データと統合して、費用対効果を確認できるようなソリューションも提供しているそうです。

また、電通デジタル様には、所属のデータサイエンティストが作った機械学習の Xstack というサービスがあります。Vertex AI など Google Cloud の製品群はもちろん、この Xstack によって出力されたスコアリングの結果なども、BigQuery に貯めているそうです。

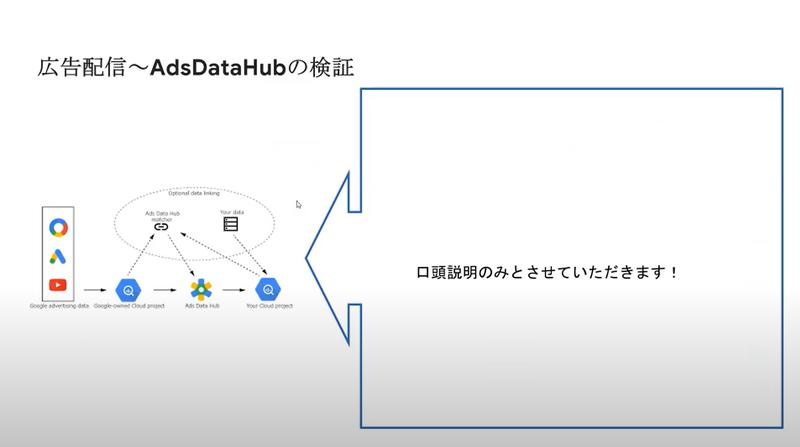

AdsDataHub は、BigQuery を使ったツールです。GA4 だけでは取得できない視聴データと紐づけてくれます。

BigQueryにデータを出力し、お客様の成果地点を共有することで始めて動きます。収集元はGaタグではなく、広告を見たというインプレッションが母数になります。Google の母数のデータに対して、成約数を紐づけて、AdsDataHubで提供しています。

もちろん、BigQueryと接続して、Looker など好きな BI ツールで可視化できます。

今回の発表では、教育業界の例を紹介してくれました。

この事例では、紹介者を通じた成約者とオンライン申し込みが一元化されていませんでした。その結果、オンライン申し込みとオフライン成約が紐づいていないため、営業の頑張りの結果なのか、広告の費用対効果なのかわかりませんでした。

そのため、CRM データベースと Web site の閲覧履歴を接合して、GA4 を使ってお客様の行動履歴を可視化できるようにしたようです。

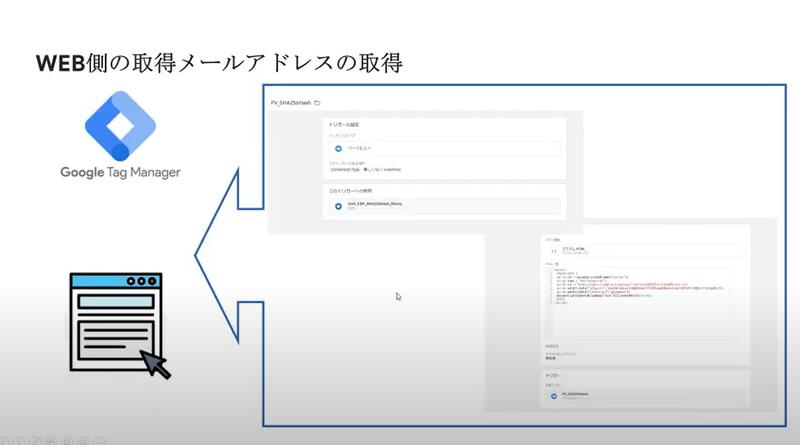

本事例では、行動履歴をトラックするために、申込者のメールアドレスをキーとして使用したそうです。ただ、Google アナリティクス には個人情報を入れることはできません。

そのため、Web上の入力フォームで入力されたメールアドレスは、GoogleTagManagerでメールアドレスをHash化処理してから登録したそうです。。

これで、オフラインの営業経由のデータと一致させ、WEB経由のデータが一元化されて整理された状態になりました。

広告を配信した後は、広告の効果検証となります。結果を検証しました。

AdsDataHubを通じて、検証できるのは、Google広告、Youtube、ディスプレイ広告です。

X-Stackを活用すると、広告配信の結果成約したという結果を検証できました。

オンラインとオフライン、WEBとアプリの行動履歴をオンライン上で一元化することで、打ち手の精度の向上につなげることができます。とても興味深い内容のご紹介をありがとうございました。

ECの構成が高まる中、リアルでの購入もある中、オフラインとオンラインを行き来するお客様に対して、一番便利な情報を提供するということが課題になっています。

私にとって、解決策ど真ん中の事例紹介でした。

福島さんありがとうございました。

(ライオン / 水谷昌史)

LT 紹介

「GA4 活用の最終解」

エクスチュア/ 大倉様

LTのトップバッターはエクスチュアの大倉さんです!

GA4活用の最終解ということで、とても興味がそそられるタイトルです…!!

発表の前に、発表する内容がどんな人におすすめなのかを伝えてくれるのは、聞き手に嬉しいですね!

私は3番目「GA4/BigQueryを活用してデータ/レポート基盤を作ろうとしている」に該当するので、ワクワクします!

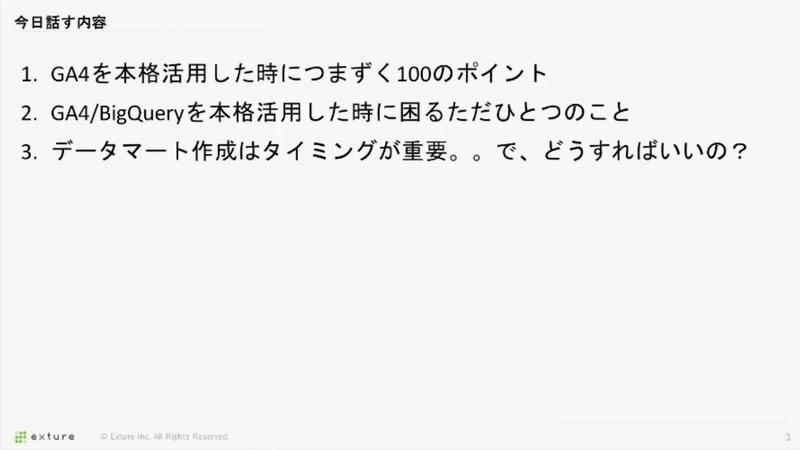

今回お話しされる内容はこちら。

出だしで「1. GA4を本格活用した時につまずく100のポイント」とあり、時間が足りるのか不安になりますが、内容は気になるものばかり…!!!

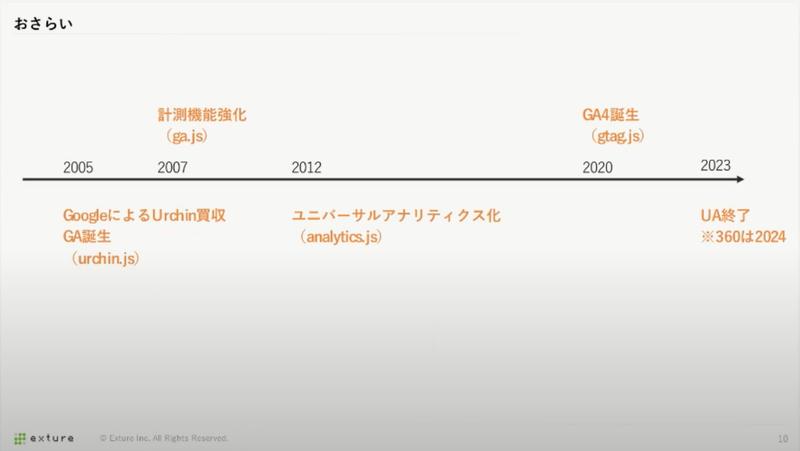

まずはGoogle アナリティクスの歴史のおさらいから。

特に今年はUA(Universal Analytics)が終了するということで、Google アナリティクスも大きく変わってきている節目の年だなと実感したのとともに、GAが誕生してからもうすぐで約18年という歴史の長さにも驚き。18年前、私はまだ小学生だったので、進化を重ねてきているツールなんだなと感じました。

ここで大倉さんからよくURLに付与されているクエリパラメータの “utm_xxx” の”utm”は、Google買収したUrchin(urchin.js)が名残になっているとおっしゃっていて、豆知識を手に入れることができました。

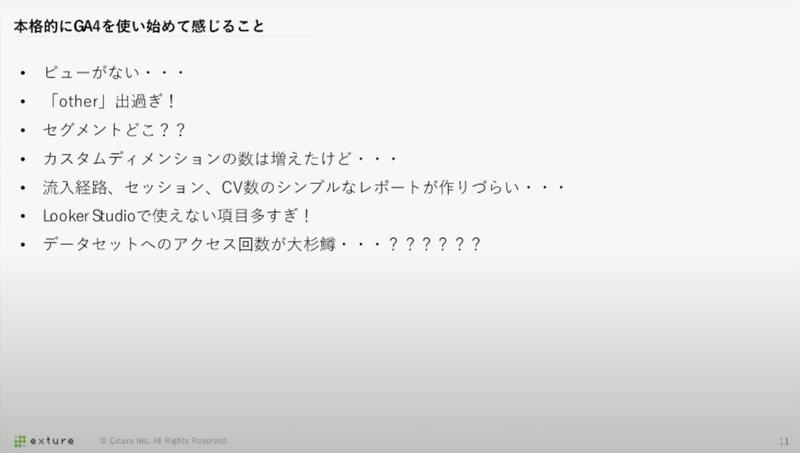

本格的にGA4を使い始めて感じることについて、最近はUA(Universal Analytics)が終了することに伴い多くの方がGA4へ乗り換えをしていますが、機能が充実はしたもののいきなり乗り換えする際につまずく部分、UAに比べて情報がまだ少ない分、苦労する部分が多いので、まさにここに書いてあるわかるなと、私は何度も頷いてしまいました。

そんな方に朗報…!!!

なんとその課題、「BigQueryで全部解決できます」(強い)

どうやらGA4で感じる課題は全てBigQueryで解決できてしまうらしい。。。

一体どういうことなのでしょうか。

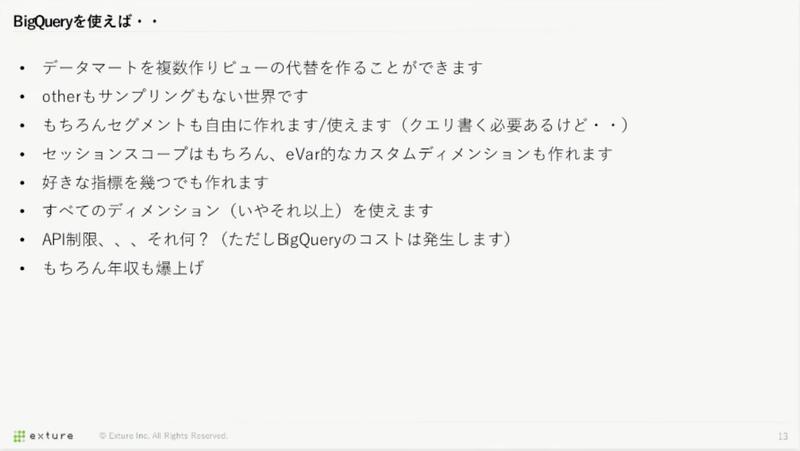

BigQueryを使えば(クエリを書く必要はあるものの)、GA4のRawのデータを用いてさまざまなことができるようになるとのこと。年収も爆上げしてしまうらしい(期待)

昨今さまざまな場所でエンジニアだけでなくマーケティング担当者でもSQLを使う力が求められつつあると聞きますが、GA4のデータをBigQueryにExportして自分が見たい指標を作り出す必要がある以上、職種関係なくSQLを書く力が必要な時代になってしまったのかもしれないなと感じました。

ただ、BigQueryにも困った点があるとのこと。

一体、どんな困ったことがあるのでしょうか。

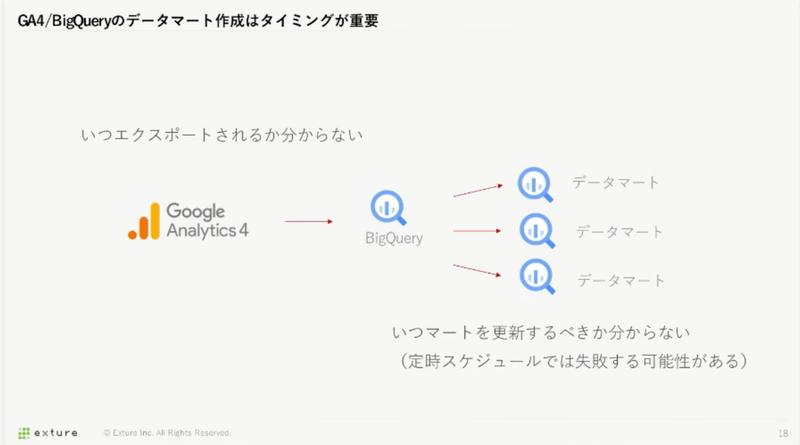

GA4からBigQueryにExportされるタイミングがバラバラになってしまうという課題。

時間が不規則に連携されてしまうため、定時を決めることができず、GA4のデータをデータマートに入れる際に、何時起動にすればいいのか決めることができません。

また、時間が不規則になるだけでなく、同日中に複数回データがExportされる仕様になっているとのこと。データ分析処理では、Cloud Composerやスケジューリングされたクエリ等を用いて、定時でバッチ処理を実行するような方法がよく用いられますが、この仕様は中々扱いづらい。。。

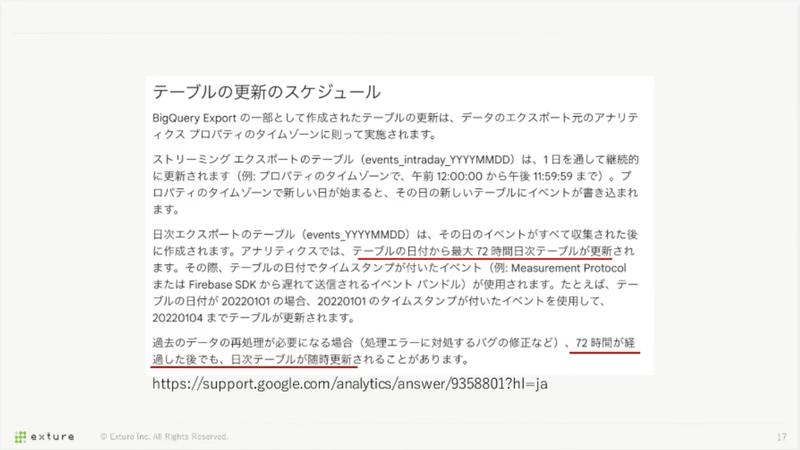

公式ドキュメントによると「テーブルの日付から最大72時間日次テーブルが更新され」と記載があり、これは例外的なケースにはなるものの「72時間が経過した後でも、日次テーブルが随時更新」される場合があるとのこと。

そうなると、定時での実行が難しく、タイミングを考えなければなりません。

スライド掲載の公式ドキュメントはこちら

https://support.google.com/analytics/answer/9358801?hl=ja

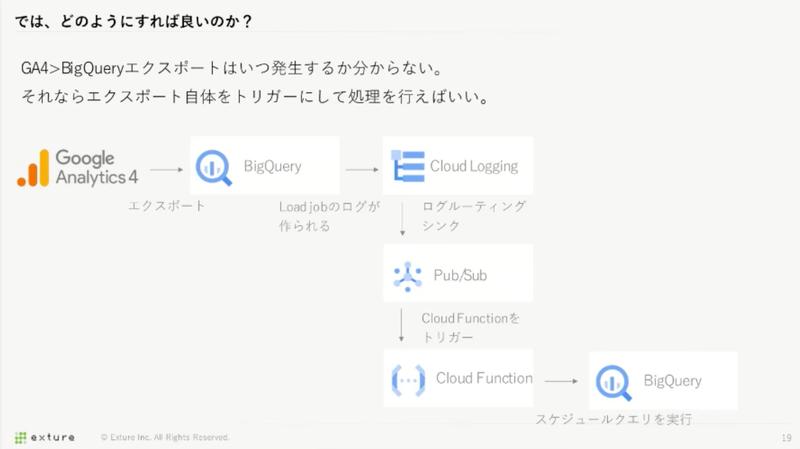

この問題に対応する方法は様々あるものの、今回のケースにおいてはGA4からBigQueryにExport・LoadされたときにCloud Loggingのシンクを利用したとのこと。指定したログが出力された時に、Pub/Subにログを送り、それをトリガーにCloudFunctionsを動かして、BigQueryのスケジュールクエリを実行するような形で取り込む対応を行ったとのことでした。

正確にデータが取得するために、一手間二手間をかけて処理を実行するような形にするのは、かなり検討/実装工数かかる対応が必要だなと感じ、ぜひここはGoogle Cloudさんにもう少し扱いやすくしてほしい部分だなと感じました。

総じて、GA4を使い始めて感じる課題は、全てBigQueryで解決できるんだ…!!と思える発表でした!

大倉さん、ご登壇ありがとうございました!

(フューチャー / 市川 浩暉)

「GA4 x dbt」

primeNumber 小林様

お二人目のLTは、primeNumber 小林さんになります。

今回、初登壇!GA4の生ログをdbtパッケージを使用して補えるかお試しいただいたLTとなります。

小林様は、あの troccoプロダクトの発案者で、troccoの現プロダクト責任者をされているレベチ(筆者基準)なお方。

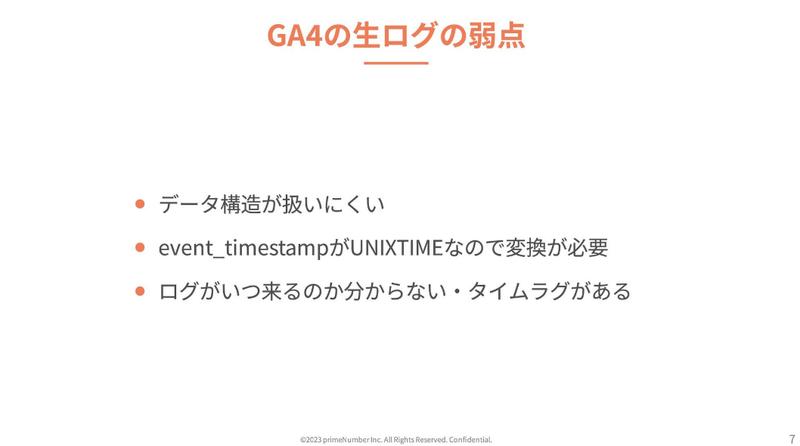

GA4の生ログをデータ分析する際の、以下の3点を解決しないと分析がし辛く不便とのこと。

どれも頭痛のタネになりそうなものばかり。

特にデータ構造が扱いにくく生ログが最初から分析のことも考えておいてくれると嬉しいですが、

そうはいかず、ひたすらクエリで頑張るのは心が折れますので、スキーマ構造は整えて使用するのが吉となります。

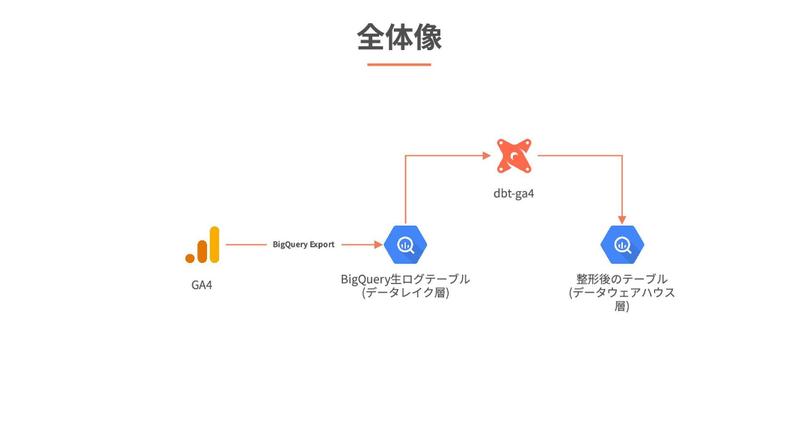

エンジニアなら1度は考える「誰かやっているはず!」とのことで発見されたのが dbt-ga4!

やっぱりあるものですね。共有知万歳!

各手順を通じて導入されて、下表のようにGA4からBQ→dbt-ga4→BQとポートバックさせる形で実装、非常に楽に整形ができたとのこと。

自分で0から作成するのは大変だったかと思うので、こういったパッケージを活用することで分析までの時間が短縮されるのは非常にありがたいですね。

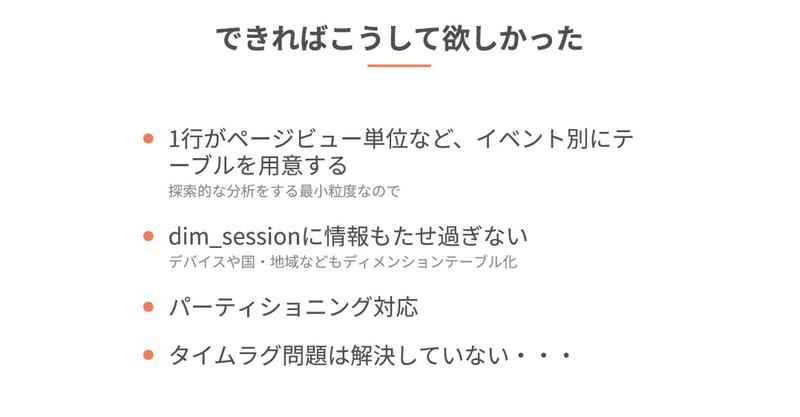

改善ポイントとしてご提示されていたのが以下の4点、使い勝手をより向上させる必要からもう一工夫が必要になるということでした。

4点目のタイムラグ問題は、各登壇者皆さんの共有認識にもなっていてGoogleさんでの解決も期待したいところ。

※運営のGooglerさんからも「プロダクト担当者へ本情報はながして改善促そう!」との話が!素晴らしい。

GA4の活用はもとよりGA4の生ログの活用も改善されるのが楽しみです!

小林さん、ご登壇ありがとうございました!

また発表資料は小林様のこちらのTwiiterアカウントにて公開されていますので、全ページをご覧になりたい方はこちらへ。

(NTT データ/ 平野圭一)

「Google アナリティクス の資格」

アクセンチュア / 青柳様

3人目のLT発表者は、アクセンチュア株式会社の青柳さんです!

昨年Jagu’e’r Awardを受賞された青柳さんですが、

過去に3回登壇され、なんと今回で4回目の登壇とのこと。(めちゃすごい)

過去分科会に参加されたブログはこちらからご覧いただけます!

- データマネジメントとGCP:データ利活用分科会 第四回イベントレポート

- 「データ人材の育成」: データ利活用分科会 第五回イベントレポート

- パネルディスカッション:社内人材育成コミュニティ連携イニシアチブ(JACO) 第9回Meet Up

さて、青柳さんがGoogle アナリティクスの資格を取得しようと思ったきっかけですが、これまでデータ分析基盤には触れてきたものの、図の左側に位置しているGoogle アナリティクス等のプロダクトにはあまり深く関わってこなかったため、内容を理解しておく必要性を感じたとのこと。

そんな中で見つけたのが、このGoogle アナリティクス個人認定資格(GAIQ)。

無償でトレーニングを受けることができ、認定試験も受けることができるようです。

資格受験料がかからないのはとても良心的ですね!

GAIQには受験条件があり、それは初級者向けコースと上級者向けコースを終了すること。

資格試験はどのように勉強をすればいいか迷いがちですが、

こういった形で道標を示してくれていると勉強を進めやすくて良いなと思いました。

コースの内容は動画形式になっていて、日本語の字幕がついているので安心です。

Google Cloudの学習教材の一つである、Google Cloud Skills Boostと同じような画面構成になっていて、勉強のしやすさを感じました。

GA4がいまいち何かよくわからない方、

UAからGA4に乗り換えてからいまいちキャッチアップができていない方、朗報です。

実は、GA4の内容を学べるコンテンツもありますので、トレーニングに参加して理解を深めていくことができます。

こちらからアクセスすることが可能です!

https://skillshop.exceedlms.com/student/catalog/list?category_ids=6440-google-4

元々GAの基礎知識がない中で、隙間時間に動画を見ながら、2週間程度で合格されたのはすごいなと感じました。業務を進める中で資格試験の勉強をするというのは、本当に大変なこと(実体験)ですが、スキマ時間を見つけながら勉強されていて、とても刺激を受けました!

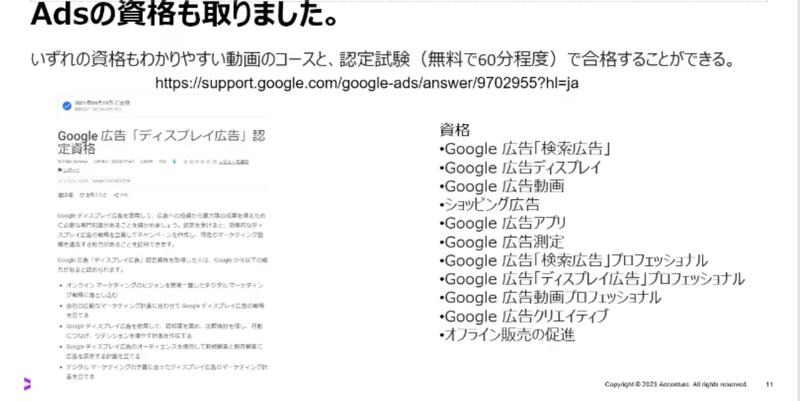

また、青柳さんはGoogle アナリティクスの資格に加えて、Google広告「ディスプレイ広告」の認定資格にも合格されたとのこと。

広告領域だけでも、これだけの資格が用意されているのはとてもびっくりですね!

私は、自分の中で資格取得は学習のマイルストンとして位置付けているので、

こういった形で資格がたくさん用意されていると、学習を進めやすくなって良いなと感じました。

GAIQは認定期間が18ヶ月程度ということもあり、一般的なベンダー資格と比べると短めな印象を受けましたが、トレーニング&資格受験が無料、ということで再認定を受けやすい試験だなと感じました!

最後のQ&Aパートでは、Google広告の試験は仕様がよく変わるので体で覚えていくのもおすすめ(電通デジタル 福島さん)という普段広告運用をされている方からの生の声を聞けて、とても勉強になった回でした!

(フューチャー / 市川 浩暉)

所感・まとめ

今回は GA4 をテーマにして基調講演と LT 3本を発表いただきました。登壇いただいた福島さん、大倉さん、小林さん、青柳さんありがとうございました。私も、GA4 を使っていましたが、もっと知って、もっともっと GA4 のデータ活用に取り組んでいきたいと思いました。

青柳さんから紹介いただいた資格も、無料で始められるのが素晴らしいですね!そして、あとは体で覚えて運用、活用に取り組んでいきたいです。Web ページから得られるユーザーデータは、ユーザーからの無意識なフィードバックです。そのフィードバックから、さらにユーザーを惹きつけるような取り組みに活かしていきたいです!

みなさん、ステキなご発表、ありがとうございました!!